Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

時間:2024-12-24 17:52 來源:未知 作者:admin 閱讀:次

著實有點Amazing啊。

這兩天GPU圈子發生了個事兒,被網友們討論地津津樂道——有一款顯卡賣爆了。

火到什么程度呢?就是一進貨就被搶光。

GPU供不應求其實已經司空見慣了,但之所以這次能被熱議起來,是因為這款產品背后的廠家。

不是你以為的NVIDIA、AMD,而是……Intel。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

為什么會如此?

從玩家們的討論中不難得出答案——性價比夠高,2000元價位就能在2K畫質下暢玩3A游戲。

The Verge也非常“直給”地給予了一句評價:

Intel終于在GPU上拿下了一次勝利。

而這款顯卡,正是Intel不久前發布的第二代銳炫B580,售價僅2049元起。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

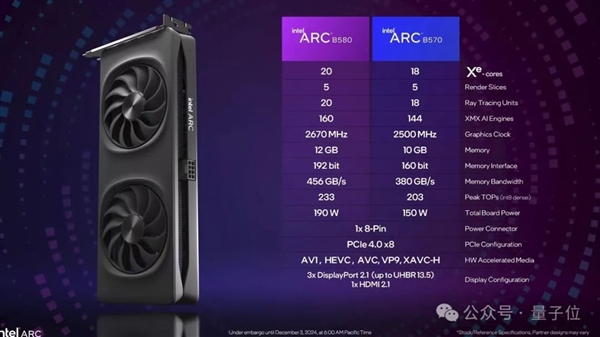

要知道,NVIDIA 299美元的RTX 4060和AMD 269美元的RX 7600,僅配備了8GB的VRAM。

但Intel的銳炫B580不僅價格比它們低,還配備了12GB的VRAM和192bit的顯存位寬。

即使是價格更低的銳炫B570(219美元,下個月上市)也配備了10GB的VRAM。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

除此之外,還有一個更有意思的事情。

雖然銳炫是游戲顯卡,但畢竟是GPU啊,于是……也有一部分人買來開始搞AI了。而這,可能會讓它未來的銷售再增三分熱度。

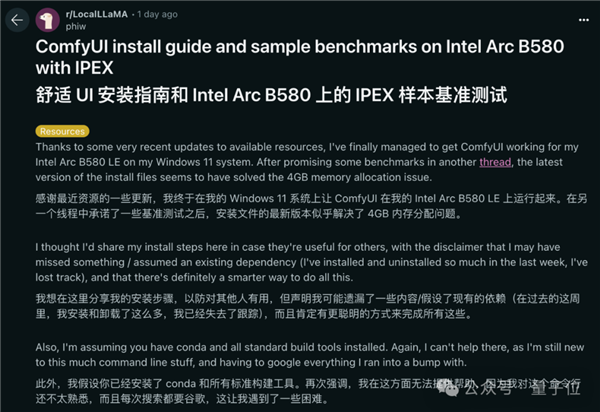

這不,有人在Reddit上就分享了怎么在銳炫B580上搞AI畫圖Comfy UI了:

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

不僅是個人用戶的嘗鮮,我們還打聽到有些企業已經著手把Intel的顯卡塞進包括工作站和服務器在內的商用計算設備中了,具體搭配的“食譜”就是:Intel至強系列CPU+銳炫顯卡。

不過暫時用的還是Intel上一代的A770,作為上一代的旗艦型號,A770有著16G大顯存,用在AI推理上,也算游刃有余。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

據可靠的消息,如此組合最為搶眼的優勢,同樣是“性價比”三字。

而由此引發的,更值得討論的一個話題應當是:

消費級顯卡搞AI,到底行不行?

首先可以看出來,無論個人還是企業,買Intel消費級顯卡來搞AI,基本都是來做AI推理的。

實際上,推理算力需求正在飛速增長,大有超過訓練算力需求之勢。

一方面,隨著行業熱議的“預訓練Scaling Law撞墻”了,像OpenAI o1/o3系列模型也開始依靠增加推理算力提高模型能力。

另一方面,AI應用落地的爆發也使得推理需求大幅增長,這些需求往往不強求算力的溢出甚至極致,即所謂硬需求不高,而是更加注重實現夠用的性能(包括并發度和時延),以及與之同步的易獲取、易部署、易使用和成本上是否夠實惠。

那么做AI推理為什么選擇Intel游戲顯卡?

正如前面分析,性價比肯定是一大考慮因素。

從硬件方面講,即使是頂級的算力卡,單卡做AI推理在面對高并發等場景時,顯存也會成為瓶頸,但升級到四卡、八卡成本又會飆升。此時,Intel A770這種2000元價位就有16G大顯存的型號,就成了兼顧性能與成本之選。

從應用方面講,很多場景其實對每秒token生成速度要求并不高,特別是有流式傳輸等優化手段,只要first token latency到位了,后面生成速度滿足一定要求,體驗就很好。

這是我們拿到的4張Intel銳炫A770顯卡跑Qwen2.5 32B模型的演示Demo,來感受一下這個速度,是不是足夠了?

看到這里可能有人要問了,用Intel顯卡跑AI,CUDA的問題怎么解決?

拿最流行的大模型推理框架之一vLLM來說,得益于開源軟件的發展,其早已實現了高級別的抽象和封裝,其實換用哪種硬件,用起來都沒差太多。

再加上Intel自己提供的開源oneAPI,就能做到很低的遷移成本。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

可能還有人要問了,那為什么不選專用AI推理加速器,比如風頭正盛的Groq、Sambanova這些?

這就要說到,多模態交互是現在AI應用的一大趨勢,無論是與AI視頻對話、數字人,還是直播、短視頻場景的一些應用,都同時會用到視頻解碼或圖形渲染能力,這就非得是通用GPU不可。

專用加速器雖然在特定任務上有優勢,但在處理多樣化需求時,通用GPU更具靈活性。

所以總結來看,用Intel顯卡搞AI推理,算力夠用,大顯存還有,可行性就有了,性價比也有了,對于現有業務來說,遷移成本更是理想。

后面能拿下多大市場,會不會成為一個趨勢,就拭目以待了。

Intel的曲線突圍

Intel消費級顯卡被企業拿去搞AI推理了,Intel自己是什么態度?

那肯定是樂見其成的,而且相當重視。

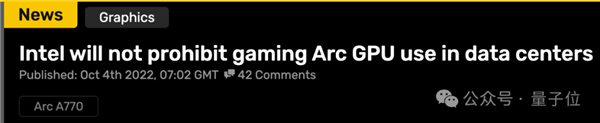

其實,Intel在兩年前剛推出銳炫系列時就采取與友商不同的策略,許可證方面明確不限制數據中心使用。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

為了方便大家用好AI,Intel的軟件團隊一直沒閑著,除了更新oneAPI,還在持續推出和更新一系列開源工具,吸粉不斷。

例如加速庫IPEX-LLM,可用于大模型的推理和微調,在GitHub上已經有6.8k star。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

以及低比特量化工具neural-compressor,也獲得2.3k star。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

從IPEX-LLM也可以看出Intel對中國市場的重視,針對中國主流的開源大模型ChatGLM、Qwen、MiniCPM等都提供了適配,中文文檔和教程也做的比較完善。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

為了方便大家選擇模型,Intel還在HuggingFace上維護了一個低比特量化模型的排行榜,設置好條件,就可以一鍵比較并篩選出自己需要的模型。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

其中性能排名靠前的,不乏Intel自己動手量化的開源社區優秀模型。

Intel新顯卡賣爆!24GB大顯存也在路上 AI玩家都來搶了

這么看下來,Intel為AI開源社區做的眾多貢獻,給企業和開發者提供了便利,也是現在大家愿意嘗試Intel顯卡的原因之一。

最后,我們還打聽到一個內幕消息:

Intel看到AI推理這個市場需求逐漸擴大后,在后續產品策略上也有所調整。2025年,Intel準備推出Battlemage系列顯卡的更大顯存版本,其容量將增至24G。以后就是現有版本繼續服務于游戲等消費級市場,24G的更大顯存版本瞄準“生產力市場”。“生產力市場”的目標用戶涵蓋了數據中心、邊緣機房、教育科研和個人開發者等。

擁有更大顯存的Intel顯卡,不僅可在AI推理需求上,也能在渲染和視頻編解碼應用上做到比專業圖形卡、工作站顯卡性價比更高。還真別說,“從游戲人間轉向打工賺錢”+“算力夠用、顯存保大”,很有可能會成為IntelGPU突圍的一招妙棋。

參考鏈接:

[1]https://www.reddit.com/r/pcgaming/comments/1hh2dvn/intel_finally_notches_a_gpu_win_confirms_銳炫_b580/

[2]https://www.techspot.com/news/105810-intel-launches-new-銳炫-battlemage-b580-b570-gaming.html

[3]videocardz.com/newz/intel-will-not-prohibit-gaming-銳炫-gpu-use-in-data-centers

[4] https://github.com/intel-analytics/ipex-llm

[5] https://github.com/intel/neural-compressor[6] https://huggingface.co/spaces/Intel/low_bit_open_llm_leaderboard

(責任編輯:admin)

最新內容

推薦內容

熱點內容

AI創作3D打印模型全流程圖

AI創作3D打印模型全流程圖 榮耀新任CEO李健發布阿爾

榮耀新任CEO李健發布阿爾 斷網也能用!安卓手機挑戰

斷網也能用!安卓手機挑戰 日本女仆咖啡廳引入AI翻譯

日本女仆咖啡廳引入AI翻譯 DeepSeek完美收官:開源勞

DeepSeek完美收官:開源勞 19歲女棋手用AI作弊!中國

19歲女棋手用AI作弊!中國